百度云网盘搜刮引擎,包罗爬虫 & 网站BaiduyunSpider

2021年03月02日

投稿作者:

围观人数:447

散布式百度网盘爬虫,利用当前更流行的手艺框架。合适小我进修以及二次开发。

爬虫基于 Scrapy,灵敏简单、易扩展,便利二次开发。利用 Scrapy-Redis 做为散布式中间件,可同时摆设多个爬虫实例,以提拔收罗效率。Web后台办理基于React,Material Design 设想气概。

依赖

MongoDB

Python3

Redis

Node.js > 8.0 (可选)

安拆

pip install -r requirements.txt

若何利用

1.运行爬虫

scrapy crawl baidupan

2.运行Web Service

cd api python rest.py

3.起头收罗

开源版目前需要通事后台办理界面,手动提交待收罗的分享链接。或者利用API体例:

POST http://localhost:5000/addUrl 表单参数: url

curl 例子

curl -X POST http://localhost:5000/addUrl \ -F url=https://pan.baidu.com/s/17BtXyO-i02gsC7h4QsKexg

爬虫运行截图

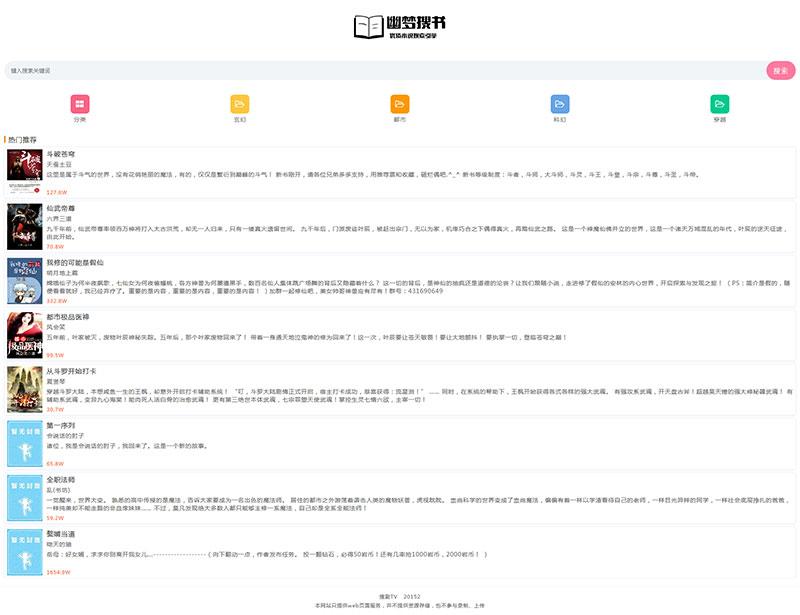

后台办理界面:

下载地址

版权说明

免责声明:本文文章内容由技术导航发布,但不代表本站的观点和立场,具体内容可自行甄别.

本文暂无评论 - 欢迎您